✅ 1. Mode Collapse (모드 붕괴)

🚩 Mode Collapse란?

Mode Collapse는 GAN의 생성자(Generator)가 데이터의 다양한 패턴을 학습하지 못하고, 제한된 패턴만 반복적으로 생성하는 현상을 의미합니다.

- 예시:

고양이 사진 데이터셋으로 학습시켰다면 다양한 고양이 이미지를 생성해야 합니다.

그러나 Mode Collapse가 발생하면 생성자는 "한 가지 고양이 유형"만 반복적으로 생성하게 됩니다.

🔍 왜 발생할까?

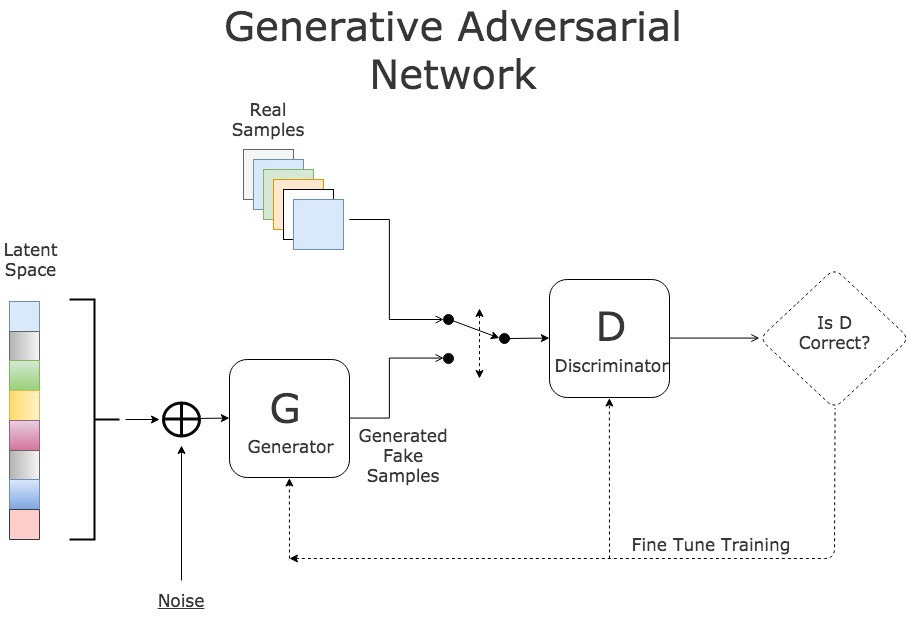

GAN은 생성자(Generator)와 판별자(Discriminator)가 경쟁하는 구조입니다. 이 과정에서:

- 생성자가 우연히 판별자를 잘 속이는 특정 패턴을 발견합니다.

- 이 패턴을 반복해서 사용하면 판별자를 속일 수 있다고 학습합니다.

- 결국 데이터의 다양성이 사라지고 특정 모드(패턴)에만 집중하게 됩니다.

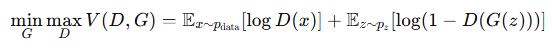

⚡️ 수학적 관점:

GAN의 목적은 실제 데이터 분포 pdata와 생성 데이터 분포 pg를 일치시키는 것입니다.

하지만 이 최적화 과정에서, 생성자 G가 pdata의 일부 모드만 근사해도 판별자 D를 속일 수 있습니다.

이로 인해 데이터의 다양한 패턴을 학습하지 못하고 모드 붕괴가 발생합니다.

🚀 해결 방법:

- Mini-batch Discrimination: 배치 내 샘플 간의 다양성을 평가하여 생성자가 다양한 출력을 생성하도록 유도합니다.

- Unrolled GAN: 판별자의 업데이트 과정을 더 길게(미리 여러 단계) 고려하여 생성자가 과도한 최적화에 빠지지 않도록 합니다.

- Wasserstein GAN (WGAN): 생성된 데이터와 실제 데이터 간의 거리(metric)를 변경하여 더 안정적으로 분포를 맞춥니다.

✅ 2. Training Instability (학습 불안정성)

🚩 Training Instability란?

GAN은 학습 과정이 불안정하게 진동하거나 수렴하지 않는 문제를 겪을 수 있습니다. 이로 인해:

- 모델이 수렴하지 않거나

- 생성 품질이 갑자기 나빠지거나

- 판별자가 너무 강해지거나 약해지는 현상이 발생합니다.

🔍 왜 발생할까?

- Gradient Vanishing (기울기 소실):

판별자가 너무 강하면 생성자는 더 이상 유용한 피드백(기울기)을 받을 수 없습니다.

이는 생성자의 학습 속도를 극도로 저하시킵니다. - Non-Convergence (비수렴 문제):

GAN의 미니맥스(minimax) 최적화는 본질적으로 어려운 문제입니다.

생성자와 판별자가 동시에 학습되므로, 최적화가 균형을 잃기 쉽습니다. - Oscillations (진동 현상):

생성자와 판별자가 서로의 변화를 따라잡지 못하고 계속 진동하게 됩니다.

이로 인해 모델이 일정한 품질에 도달하지 못합니다.

⚡️ 수학적 관점:

GAN은 Saddle Point Optimization(안장점 최적화) 문제로, 매우 민감한 학습 환경을 가집니다.

- 이 최적화 문제는 생성자 G와 판별자 가 서로 반대 방향으로 움직이는 구조이므로, 학습이 쉽게 발산하거나 진동할 수 있습니다.

🚀 해결 방법:

- Wasserstein GAN (WGAN): 기존 GAN의 교차 엔트로피 손실 대신 Wasserstein 거리를 사용하여 더 부드러운 기울기 피드백을 제공합니다.

- Gradient Penalty: 기울기의 크기를 제한하여 학습이 급격히 발산하는 것을 방지합니다.

- Spectral Normalization: 판별자의 가중치를 정규화하여 학습의 안정성을 높입니다.

- Two Time-Scale Update Rule (TTUR): 생성자와 판별자의 학습 속도를 다르게 조절하여 안정성을 개선합니다.

- Mode Collapse는 다양성의 문제입니다.

- Training Instability는 학습 과정의 문제입니다.

해당 글은 ChatGPT 의 도움을 받아 작성된 글입니다.

'😎AI > Terminology' 카테고리의 다른 글

| [Notable] Low Temperature Samples (0) | 2025.02.05 |

|---|---|

| [Notable] Evaluation Metrics (0) | 2025.02.04 |

| [Notable] Explicit Representation VS Implicit Representation (0) | 2025.01.31 |

| [Notable] Differentiable image parameterization, DIP (0) | 2025.01.21 |

| [Notable] NeRF vs Voxel vs Mesh (0) | 2025.01.21 |