Abstract

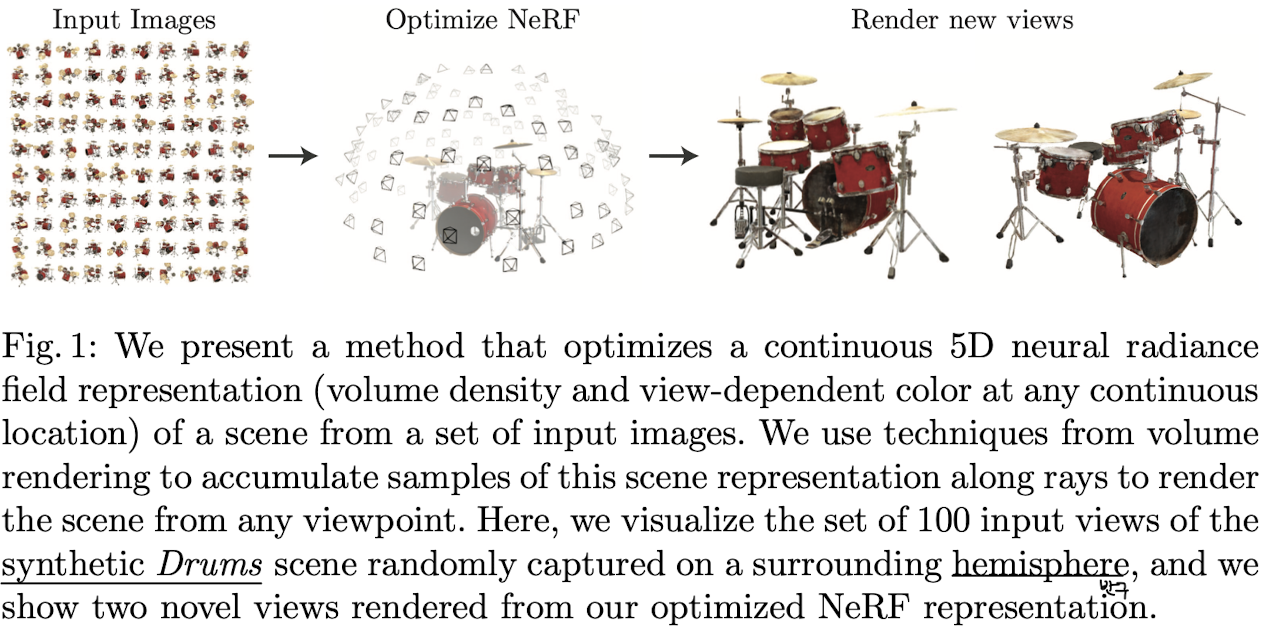

이 논문에서는 복잡한 장면의 새로운 시점을 생성하며, 기존 연구를 뛰어넘는 성능을 달성하는 방법을 제안한다.

이 방법은 소수의 입력 뷰를 사용하여 연속적인 volume scene 함수를 최적화한다.

알고리즘은 장면을 fully connected (not convolution) deep network 로 표현한다.

<방법>

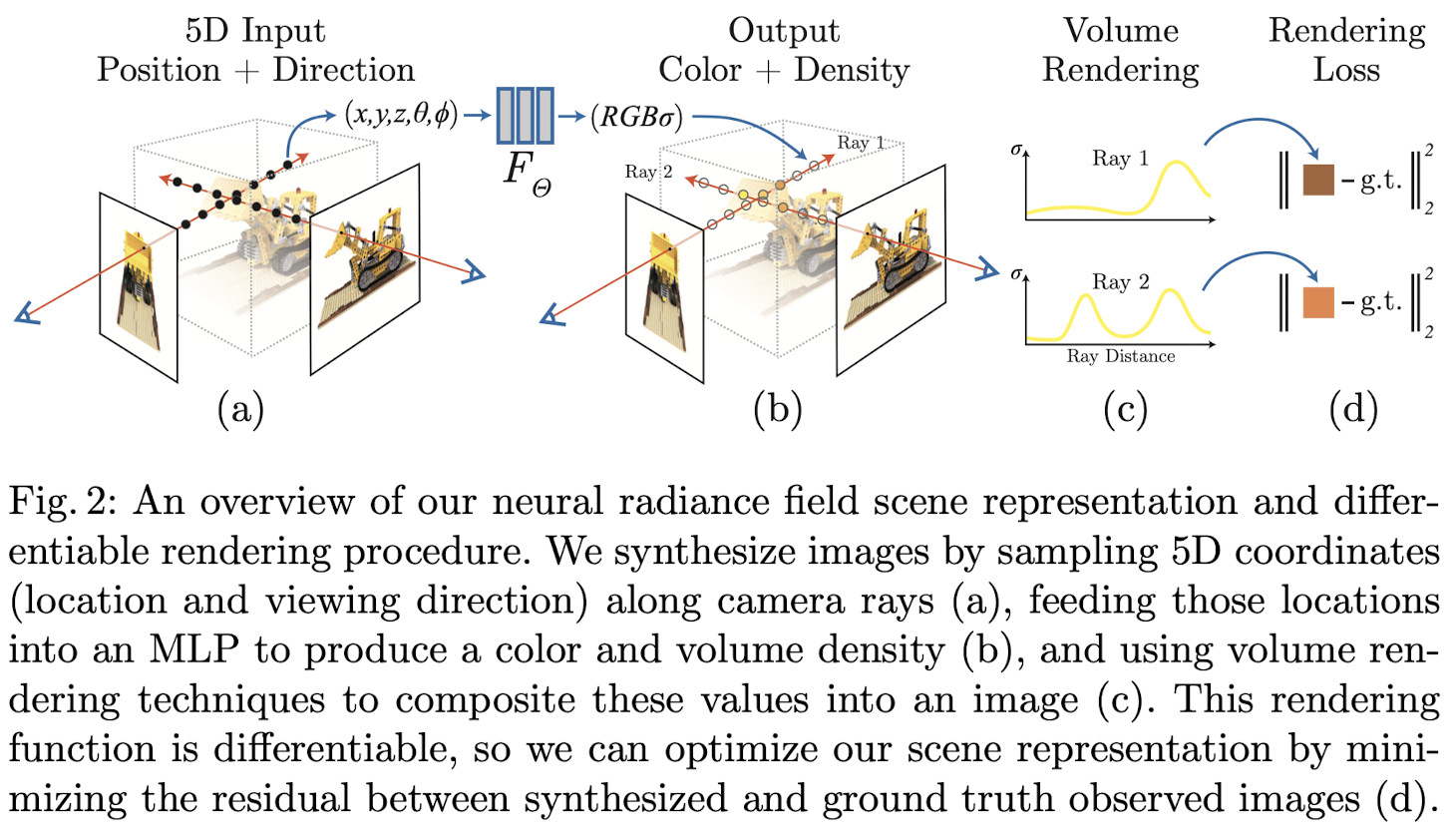

- 입력: 연속적인 5D 좌표 => 공간 위치(x, y, z) 와 시점 방향(θ, φ) 을 입력

- 출력: 해당 위치의 체적 밀도(volume density) 와 시점 종속 방출 복사광(view-dependent emitted radiance) 출력

- 합성 과정: 카메라에서 장면으로 뻗어나가는 광선(rays) 을 따라 5D 좌표(공간위치와 시점방향)를 선택한 뒤, 해당 좌표에서 신경망을 통해 계산된 색상과 밀도 값을 체적 렌더링 기법을 사용해 결합하여 최종 이미지를 생성한다.

- 최적화: 미분 가능한 체적 렌더링을 이용해 카메라 위치가 알려진 이미지 세트만으로 최적화한다.

결과적으로 신경 렌더링 및 뷰 합성에서 기존 연구보다 우수한 성능을 보인다. 뷰 합성 결과를 비디오로 확인하면 더 설득력있는 비교가 가능하다.

여기서 핵심 개념인 "Ray" 에 대해서 좀 더 알아보고 이후 논문을 읽어보고자 한다.

Ray 는 공간 상의 점 하나와 방향(각도)이 주어지면 형성되는 직선을 의미하며, NeRF에서는 이 직선 위의 여러 지점(샘플링된 점들)을 따라 장면의 정보(체적 밀도와 방출 복사광)를 계산하는 데 사용된다.

Introduction

NeRF 는 5D continuous function 을 사용해 장면을 표현하고, 이를 학습하여 고해상도의 새로운 뷰를 생성하는 뷰 합성(View Synthesis) 기술이다. 주요 특징과 기여는 다음과 같다.

1. 장면 표현 방식:

- 장면은 (x, y, z) 로 정의되는 공간 위치와 (θ, φ) 로 정의되는 시점 방향을 입력받아, 각 지점의 RGB(광량, Radiance) 과 밀도(Density) 를 출력하는 5D 연속 함수로 모델링된다.

- 밀도는 빛의 흡수/투과 정도를 제어하며, 이를 통해 장면의 구조와 외형을 재현한다.

2. NeRF 의 신경망 구조:

- MLP (다층 퍼셉트론) 기반의 fully-connected layer 를 사용하며 5D 좌표를 input 으로 받아 시점 의존적인 RGB 색상과 Density 값을 output으로 출력한다.

- Convolution Layer 없이도 연속적인 장면의 복잡한 기하학과 재질을 표현할 수 있다.

3. 이미지 렌더링 과정:

- 특정 시점에서의 이미지를 생성하기 위해 다음 세 단계를 수행한다.

1. 카메라 광선(ray) 생성: 광선을 따라 3D 공간의 샘플링 포인트를 생성한다.

2. MLP로 색상과 밀도 계산: 샘플링 포인트와 시점 방향을 MLP 에 입력하여 해당 지점의 색상과 밀도를 예측한다.

3. 체적 렌더링(Volume rendering): 예측된 색상과 밀도를 합성하여 2D 이미지를 생성한다.

4. 최적화 방법:

- 미분 가능한(Differentiable) 볼륨 렌더링 기법을 사용해, 관찰된 이미지와 예측된 이미지 간의 오류를 최소화하도록 학습한다.

- 여러 관점에서 이미지를 비교하면서 장면의 구조를 일관성 있게 학습한다.

5. 기술적 개선:

- 단순 구현의 한계를 극복하기 위해 다음과 같은 두 가지 핵심 기법을 제안한다.

- Positional Encoding: 입력 5D 좌표를 high-frequency (고주파수) 표현으로 변환해 네트워크가 복잡한 세부 정보를 학습할 수 있도록 지원한다.

- Hierarchical Sampling: 중요한 영역에 계산 자원을 집중해 고주파수 장면 표현을 더 효율적으로 샘플링한다.

6. 장점과 성능

- 기존 체적 표현법(Voxel Grid) 보다 저장 공간이 적게 들면서도, 복잡한 기하학과 외형을 효율적으로 모델링한다.

- 기존 뷰 합성 기법이나 딥러닝 기반 3D 표현법을 능가하는 성능을 보인다.

- 실험 결과, NeRF 는 고해상도 포토리얼리스틱 뷰를 생성하며, 자연 환경에서 캡처된 RGB 이미지로 학습 가능함을 보여준다.

Related Work

1. Neural 3D Shape Representation

1. 기본 개념

- 3D 형상 신경망(MLP) 으로 모델링 하여 각 (x, y, z) 좌표를 서명 거리 함수(Signed Distance Function, SDF) 또는 점유 필드(Occupancy Field) 로 매핑

- 주요 연구:

- SDF 활용: 좌표를 거리 함수로 매핑해 형상을 연속적으로 표현

- 점유 필드 활용: 3D 표면을 점유도로 나타냄

2. 한계점

- 대부분의 연구가 3D geometry(ShapeNet) 과 같은 합성 데이터셋의 정답 라벨에 의존한다.

- 이러한 정답 라벨 없이 2D 이미지만으로 학습하기 위해 미분 가능한 렌더링을 도입한 연구들이 등장:

- 점유 필드를 사용해 광선 교차점을 계산하고, 해당 위치의 색상 예측

- 신경망 활용하여 점진적으로 표면을 찾는 방식

3. 결과와 한계

- 고해상도 기하학 표현이 가능하지만 복잡한 구조 표현에는 제약이 있으며, 낮은 해상도의 매끄럽지 않은 결과물 생성

2. View Synthesis and Image-Based Rendering

1. 뷰 합성 기술

- 조밀한 뷰 샘플링: 조민하게 관측된 이미지들을 보간(interpolation)하여 새로운 뷰 생성

- 희소한(sparse) 뷰 샘플링:

- 관측된 이미지를 기반으로 기하학적 형상과 외형 정보를 예측

- 대표적으로 Mesh-based Representations:

- 표면 외형(defuse/view 종속)을 모델링

- 미분 가능한 레스터라이저나 경로 추적기(path tracer)를 통해 최적화

2. Volumetric 접근법

- 복잡한 형상 및 재질 표현에 유리하며, 최적화가 용이하고 메시 기반 방법보다 시각적 결함이 적다

- 초기 연구: 관찰된 이미지를 사용하여 voxel grid에 색상 할당

- 이후 연구:

- 대규모 데이터셋을 활용해 입력 이미지로부터 샘플링된 볼륨 데이터를 예측

- CNN 과 볼륨 샘플링을 결합하여 3D 공간 표현 최적화

3. 한계점:

- 해상도 제한 (볼륨 샘플링의 시간 및 공간 복잡도의 한계로 인해 고해상도 이미지 생성 어려움)

- 해결방안: 연속 볼륨 표현 => NeRF 는 연속적 볼륨을 신경망 파라미터 내에 압축적으로 인코딩하여 기존 기법 대비 저장 공간 감소 및 고품질 렌더링 동시에 달성

결론적으로 NeRF 는 이전 연구들의 한계 극복을 위해 ⭐️ 연속적인 5D Radiance field 표현을 도입하였다.

Neural Radiance Field Scene Representation

장면은 5차원 함수로 표현되며, 이 함수는 다음과 같은 입출력을 갖는다.

- 입력: 3차원 위치 (x, y, z) 와 2차원 시점 방향 (θ, φ)

- 출력: 색상 c = (r, g, b), 부피 밀도 σ

모델 설계:

1. 시점 방향 인코딩

- 시점 방향은 3차원 직교 단위 벡터(3D Cartesian unit vector) d 로 변환된다.

2. 함수 근사화

- 다층 퍼셉트론(MLP) Fθ 가 다음 매핑을 근사한다.

여기서 θ 는 MLP의 가중치이다.

3. 일관성 제약 조건

- 부피 밀도 σ: 공간적 위치 x 만을 입력으로 사용하여 예측한다. (only use location X)

- 색상 c: 위치 X 와 시점 방향 d 를 모두 사용하여 예측한다.

구체적 설계 방식:

- MLP 는 x 를 입력으로 받아 8개의 fully connected layer (ReLU 활성화 함수, 레이어당 256 채널) 로 처리한다.

- 이 과정에서 σ 와 256차원의 특성 벡터를 출력한다.

- 특성 벡터는 시점 방향 d 와 결합되어 1개의 추가 fully connected layer (ReLU 활성화 함수, 128 채널) 로 전달되며, 여기서 시점 의존적인 RGB 색상이 출력된다.

시점 의존성의 효과:

- 시점 의존성을 포함하면 non-Lambertian effects (예: 반사광) 을 더 잘 표현할 수 있다. (Fig. 3 참고)

- 시점 의존성을 제외한 모델 (입력에 x 만 사용)은 반사광(Specularities)을 제대로 표현하지 못한다. (Fig. 4 참고)

Volume Rendering with Radiance Fields

(이 내용은 밑에 솔아표 부록으로 올려놓는 note 에 좀 더 자세히 기술하도록 하겠다.)

5차원 Neural Radiance Field 는 공간의 임의의 점에서 부피의 밀도 σ 와 방출되는 복사(r, g, b) 를 통해 장면을 표현한다.

장면을 통과하는 임의의 광선(Ray) 색상을 렌더링 하기 위해 이 논문에서는 classical volume rendering 의 원리를 사용한다.

1. 부피 밀도 (σ(x)) 의 해석:

- 부피 밀도는 ray 가 특정 위치 x 의 미소 입자(infinitesimal particle)에서 종료될 확률을 나타낸다.

- 카메라 광선 r(t) = o + td 의 색상 C(r) 은 다음과 같이 계산된다.

- T(t): 누적 투과율(accumulated transmittance), 즉 광선이 tn에서 t 까지 다른 입자와 충돌하지 않을 확률

2. 렌더링 프로세스:

- 원하는 가상 카메라의 각 픽셀을 통과하는 광선에 대해 위의 색상 적분 C(r) 를 계산해야 한다.

- 이를 위해 수치적 적분(quadrature) 방식을 사용한다.

3. 샘플링 기법

- ⭐️ Stratified Sampling (계층적 샘플링)

- 구간 [tn, tf] 을 N 개의 동일한 간격으로 나누고, 각 구간에서 무작위로 한 샘플을 추출한다.

- 이 방법은 MLP 가 연속적인 위치에서 평가되도록 하여 연속 장면 표현이 가능하게 만든다.

4. 색상 C(r) 의 수치적 근사

- 샘플 (ci, σi) 를 사용하여 C(r) 을 다음과 같이 계산한다.

- 이 계산 방식은 전통적 alpha compositing (알파 합성) 과 유사하며, 알파 값이 다음과 같이 환원된다.

Optimizing a Neural Radiance Field

이 섹션에서는 NeRF 를 고해상도 복잡한 장면으로 효율적으로 표현하기 위한 두 가지 개선 방법을 제안한다.

1. Positional Encoding: 입력 좌표를 고차원 공간으로 매핑하여 신경망이 high-frequency (고주파) 정보를 잘 학습할 수 있도록 도움

2. Hierarchical Sampling: 효율적으로 고주파 표현을 샘플링

⭐️ Positional encoding

- 신경망은 이론적으로 모든 함수를 근사할 수 있지만 (Universal Approcimation Theorm, 보편 근사 정리), 실제로는 저주파(low-frequency) 함수를 학습하는 경향이 있다.

- Rahaman et al.의 연구에 따르면, 입력을 고주파 함수로 매핑한 후 신경망에 전달하면 고주파 변동이 포함된 데이터를 더 잘 근사할 수 있다.

방법:

1. 네트워크 구성:

- 기존의 NeRF 네트워크 Fθ 를 두 함수의 조합으로 재구성한다.

2. 인코딩 함수 γ:

- 입력을 고차원 공간 R^2L 으로 매핑한다.

- 각 좌표값 x와 뷰잉 방향 d의 세 성분에 대해 별도로 적용

- x: [-1, 1] 범위로 정규화

- d: 단위 벡터로 [−1, 1] 범위를 가짐

- 실험 설정: L=10 (위치 x), L=4 (뷰잉 방향 d)

3. 유사한 사례

- Transformer 모델: 순서 개념이 없는 구조에서 토큰의 위치를 제공하기 위해 사용했다.

- 본 연구에서는 연속적인 입력 좌표를 고차원 공간으로 매핑하여 고주파 함수를 더 잘 근사하기 위해 활용한다.

- 3D 단백질 구조 모델링에서도 비슷한 접근법이 사용된다.

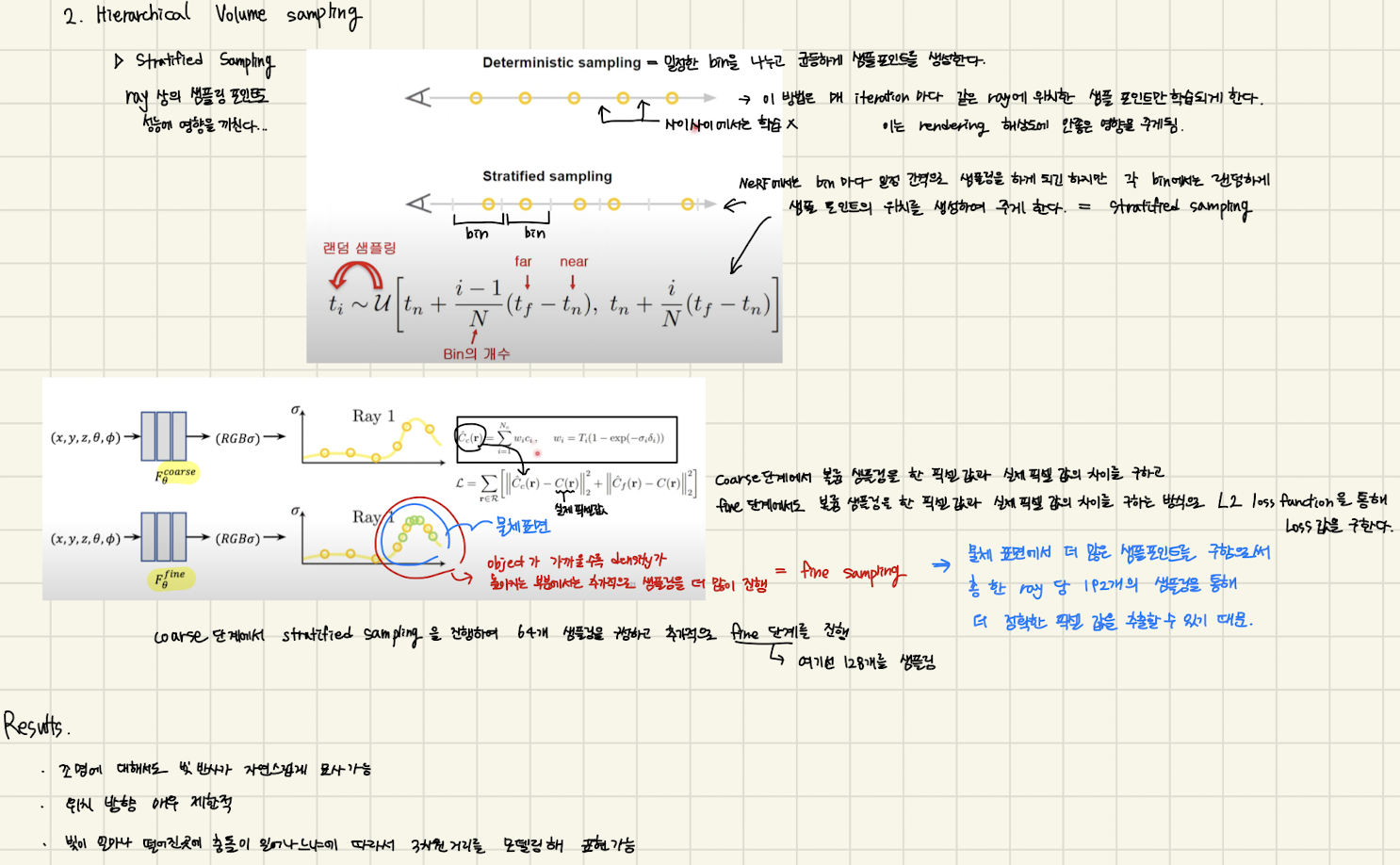

⭐️ Hierarchical volume sampling

문제점:

- NeRF 네트워크는 카메라 광선(rays) 마다 균일하게 N 개의 샘플을 생성하여 평가하지만, 이는 효율성이 떨어진다.

- 자유 공간(free space) 및 가려진 영역(occluded regions) 은 최종 렌더링에 거의 기여하지 않음에도 불구하고 샘플링됨

해결책:

- Hierarchical representation

- 장면을 표현하기 위해 두 개의 네트워크("coarse" 와 "fine") 를 동시에 최적화한다.

- 이를 통해 중요한 영역에 샘플을 더 집중시켜 렌더링 효율성을 증가시킨다.

방법:

1. 첫 번째 샘플링:

- Stratified Sampling 으로 Nc 개의 샘플 위치를 생성하고, Coarse 네트워크로 평가한다.

- Eq. 5 에 따라, 각 샘플의 색상 Ci와 가중치 Wi 를 계산한다.

- wi 를 정규화하여 ray 상에서의 확률 분포(PDF) 를 생성한다.

2. 두 번째 샘플링:

- 역변환 샘플링(Inverse Transform Sampling) 을 이용해 이 확률 분포에서 Nf 개의 새로운 샘플 위치를 추가 생성한다.

- Fine 네트워크는 Nc+ Nf 개의 샘플(첫번째와 두번째 샘플을 모두 포함)을 평가

- 최종 색상은 Eq. 3 에 따라 계산한다.

3. 효과:

- 중요한 영역에 샘플 집중

- 샘플을 중요 영역으로 비균일하게 배치한다.

- 이는 전통적 중요도 샘플링(Importance Sampling) 과 유사하지만, 각 샘플을 독립적인 추정치로 처리하지 않고 전체 적분 영역을 비균일하게 분할한다.

Implementation details

<최적화 과정>

- 입력 데이터:

- RGB 이미지, 카메라의 포즈 및 내부 파라미터, 장면 경계 정보.

- 실험 데이터:

- 합성 데이터는 실제 카메라 정보를 사용했다.

- 실제 데이터는 COLMAP 을 사용하여 카메라 파라미터를 추정했다.

- 최적화 알고리즘:

1. 랜덤으로 4,096개의 광선 배치 샘플링

2. coarse 네트워크: Nc = 64 개의 샘플 평가

3. fine 네트워크: 추가로 Nf = 128 개의 샘플 평가

4. Eq. 6 에 따라 손실(Loss) 계산 => L2 loss function 사용

<실험 설정>

- 최적화 세부 사항:

- 옵티마이저: Adam.

- 초기 학습률: 5 x 10^-4, 최종 학습률: 5 x 10^-5

- 학습률은 지수적으로 감소시켰다.

- 일반적인 최적화 반복 수: 100k ~ 300k

- 단일 NVIDIA V100 GPU에서 1 ~ 2일 소요. => 세상에 정말 너무 느리다 ‼️

Result

이 논문에서는 정량적 결과(Tab. 1)와 정성적 결과(Fig. 8, Fig. 6)를 통해 이전 연구보다의 우수성을 입증하며 디자인 선택을 검증하기 위한 다양한 제거 연구(ablations) 도 제공했다.(Tab. 2)

Datasets

1. 객체의 합성 렌더링

이 논문에서는 두 가지 합성 객체 렌더링 데이터셋에서 실험 결과를 보여준다. (Table 1의 “Diffuse Synthetic 360°”와 “Realistic Synthetic 360°”)

- DeepVoxels 데이터셋: 단순한 기하학을 가진 4개의 램버시안(Lambertian) 객체를 포함, 각 객체는 상부 반구에서 샘플링된 뷰포인트에서 512×512 픽셀로 렌더링(입력 479개, 테스트 1000개)

- 직접 생성한 데이터셋: 복잡한 기하학과 현실적인 비램버시안(Non-Lambertian) 재질을 가진 8개의 객체 이미지 포함, 상부 반구에서 샘플링된 뷰포인트로 렌더링된 객체 6개, 완전 구형으로 샘플링된 객체 2개, 각 장면당 입력 이미지 100개, 테스트 이미지 200개, 모든 이미지 해상도는 800×800 픽셀

2. 복잡한 장면의 실제 이미지

복잡한 실제 장면에서 실험 결과를 보여준다.(Table 1 의 “Real Forward-Facing”)

- 데이터셋 구성: 휴대폰으로 대략적으로 전방을 향하는 이미지 8개 장면 캡처, 5개는 LLFF 논문에서 가져온 이미지이고, 3개는 직접 캡처한 이미지, 각 장면당 20~62개의 이미지로 구성되며, 그중 1/8은 테스트 세트로 사용, 모든 이미지의 해상도는 1008×756 픽셀

Comparisons

NeRF 모델을 평가하기 위해 현재 최상위 성능을 보이는 뷰 합성 기술과 비교하였다. 모든 방법은 동일한 입력 뷰 집합을 사용하여 각 장면에 대해 별도의 네트워크를 훈련한다. 단, Local Light Field Fusion (LLFF) 은 대규모 데이터셋에서 단일 3D 컨볼루션 네트워크를 훈련한 후, 테스트 시 새로운 장면의 입력 이미지를 처리하는 데 동일한 훈련 네트워크를 사용한다.

1. Neural Volumes (NV)

- 특징: 관심 객체가 별도의 배경 앞의 경계된 볼륨 내에 완전히 위치한 경우 새로운 뷰를 합성한다.

- 구현:

- 깊이 3D 컨볼루션 네트워크를 최적화하여 discreted RGBα 복셀 그리드 (128^3 샘플) 와 3D 왜곡(warp) 그리드 (32^3) 샘플을 예측한다.

- 새로운 뷰는 왜곡된 복셀 그리드를 통해 카메라 광선을 이동시켜 렌더링한다.

2. Scene Representation Networks (SRN)

- 특징: 장면을 불투명한 표면으로 표현하며, 이는 MLP로 암묵적으로 정의되고, 각 (x, y, z) 좌표를 특징 벡터로 매핑- 구현:

- 깊이 3D 컨볼루션 네트워크를 최적화하여 discreted RGBα 복셀 그리드 (128^3 샘플) 와 3D 왜곡(warp) 그리드 (32^3) 샘플을 예측한다.

- 새로운 뷰는 왜곡된 복셀 그리드를 통해 카메라 광선을 이동시켜 렌더링한다.

3. Local Light Field Fusion (LLFF)

- 특징: 잘 샘플링된 전방-대면 장면에서 포토리얼리스틱한 새로운 뷰를 생성

- 구현:

- 훈련된 3D 컨볼루션 네트워크를 사용하여 각 입력 뷰에 대해 프러스텀(frustum)-샘플링된 RGBα 그리드 (멀티플레인 이미지 또는 MPI)를 예측한다.

- 새로운 뷰는 알파 합성과 인접 MPI 혼합을 통해 렌더링 된다.

Discussion

- 모델 성능 비교:

- NV와 SRN처럼 각 장면에 대해 별도의 네트워크를 최적화하는 베이스라인을 모든 시나리오에서 완전히 능가했다.

- LLFF와 비교해, 입력 이미지만 훈련 데이터로 사용하면서도 대부분의 메트릭에서 정량적, 정성적으로 우수한 렌더링을 생성했다.

- 각 방법의 한계:

- SRN: 지오메트리와 텍스처가 지나치게 부드럽게 표현되며, 카메라 광선당 단일 깊이와 색상만 선택하는 방식이 뷰 합성의 표현력을 제한한다.

- NV: 볼륨형 지오메트리와 외형을 비교적 상세하게 캡처할 수 있지만, 128³ 복셀 그리드를 사용하는 명시적 구조로 인해 고해상도에서 세밀한 디테일을 표현하는 데 한계가 있다.

- LLFF: 샘플링 지침(입력 뷰 간의 차이가 64 픽셀을 초과하지 않도록 권장)을 따른다. 그러나 이는 400-500 픽셀 차이를 가진 합성 데이터셋에서 올바른 지오메트리를 예측하지 못하게 만든다. LLFF는 서로 다른 장면 표현을 혼합하여 렌더링하므로 일관성 없는 시각적 표현을 생성하며, 이는 보조 영상에서 명확히 드러난다.

- 시간과 메모리의 실용적 트레이드오프:

- 단일 장면 기반의 비교 방법들은 장면당 최소 12시간의 훈련 시간이 필요

- LLFF: 입력 데이터셋을 처리하는 데 10분 미만이 소요되지만, 입력 이미지당 거대한 3D 복셀 그리드(15GB 이상)를 생성하여 저장 요구량이 매우 크다.

- NeRF 방법: 네트워크 가중치에 5MB만 필요하며, 이는 LLFF 대비 약 3000배 압축된 결과로, 입력 이미지 자체보다도 적은 메모리를 요구한다. => 애초에 convolution 도 아니고 FC layer로 몇개 층 붙여서 모델을 구현한것이 모델 자체가 매우 가볍다는 뜻...

Ablation studies

- 알고리즘의 설계 선택과 매개변수 검증:

- “Realistic Synthetic 360°” 장면에서 검증을 진행

- 참조 모델: Row 9가 완전한 모델

- 구성 요소 제거 실험:

- Row 1: 최소 구성 모델 (위치 인코딩(PE), 시점 의존성(VD), 계층적 샘플링(H) 제거)

- Row 2–4: 각 구성 요소를 하나씩 제거했을 때, 위치 인코딩(PE)과 시점 의존성(VD)이 가장 큰 성능 향상을 제공하며, 계층적 샘플링(H)이 그 뒤를 이었다.

- 입력 이미지 수 감소 실험:

- Row 5–6: 입력 이미지 수를 줄일수록 성능이 감소

- 단, 25장의 입력 이미지만 사용해도 NV, SRN, LLFF가 100장으로 얻은 성능을 모든 메트릭에서 능가

- 최대 주파수 매개변수 L 검증:

- Row 7–8: 위치 인코딩에서 x에 사용된 최대 주파수 L에 따라 성능 변화를 확인

- 주파수를 5로 줄이면 성능이 감소했지만, 10에서 15로 늘려도 성능 향상이 없었다.

- 이는 2^L이 샘플링된 입력 이미지에서 나타나는 최대 주파수 (약 1024)를 초과할 경우, 더 이상 이점이 없기 때문이라고 분석됨

Conclusion

이 연구는 객체와 장면을 연속 함수로 나타내기 위해 MLP 를 사용하는 기존 연구의 결함을 직접적으로 해결한다.

- 5D NeRF 로 장면을 표현하는 기존의 딥 컨볼루션 네트워크를 훈련하여 이산적인 복셀 표현을 출력하는 방식보다 더 나은 렌더링 결과를 생성한다는 것을 입증했다.

- 5D 신경 방사 필드: 3D 위치와 2D 시점 방향을 입력받아 볼륨 밀도와 시점 의존적인 방사광(RGB) 을 출력하는 MLP

- 계층적 샘플링 전략을 제안하여 훈련과 테스트에서 샘플 효율성을 높였지만, 여전히 신경 방사 필드를 효율적으로 최적화하고 렌더링하는 기술에 대해 더 많은 연구가 필요

- 향후 연구 방향:

- 해석 가능성: 복셀 그리드나 메시와 같은 샘플 기반 표현은 렌더링 품질과 실패 사례를 예상하는 데 유용. 그러나, 장면을 딥 뉴럴 네트워크의 가중치에 암묵적으로 인코딩하는 경우 이러한 문제를 분석하는 방법이 명확하지 않다.

- 이 연구는 현실 세계의 이미지를 기반으로 한 그래픽 파이프라인으로의 발전에 기여한다. 이는 실제 객체와 장면의 이미지에서 최적화된 신경 방사 필드로 구성된 복잡한 장면을 생성하는 데 기여할 수 있다.

아래는 논문 공부를 하면서 작성한 노트입니다. 필기본이 더 이해가 잘 갈 수도 있기 때문에 참고용으로 봐주시면 감사드리겠습니다.

아래는 좀 더 내용 보충하여 이해 위해 유튜브 강의를 보고, 정리한 필기본입니다.

긴 글 읽어주셔서 감사합니다, 공부한 걸 정리할 목적으로 작성된 글입니다.

NeRF 모델은 3D reconstruction 에 관한 연구를 하기 위해서 필수되는 논문이기 때문에 더욱 깊이 있게 학습하면 좋을것 같습니다!

피드백에 관련된 댓글 작성해주시면 감사히 생각하겠습니다. 🥸